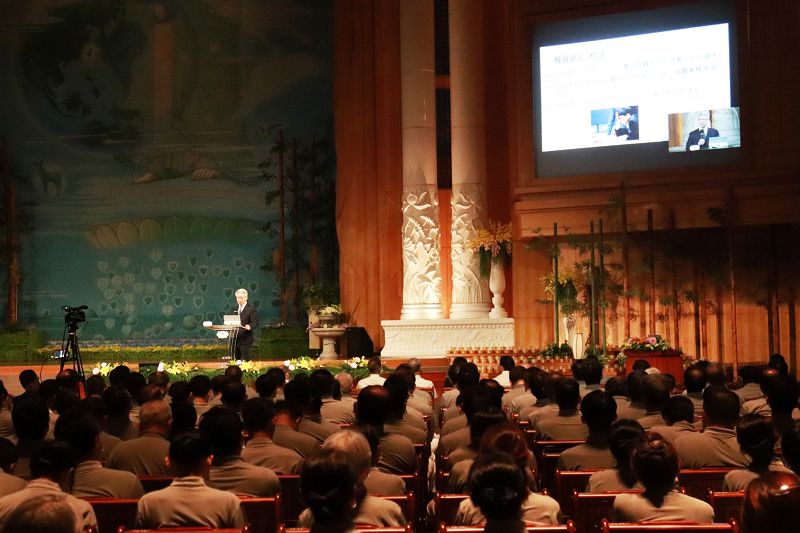

在2024年9月28日的慈濟法脈宗門營隊中,中央研究院廖俊智院長以「人 · 工智慧」為題,分享人工智慧發展的過去、現在和未來展望。談到人工智慧(AI)與人類之間的關係,廖院長說,我們應該以人為本來看待AI,而不是僅僅依賴機器的計算能力。他也提醒大家,人工智慧的真正意義在於服務於人類,而非替人類投機取巧或危害社會。

淺談AI歷史,從機器學習到大型語言模型

廖院長首先提到,早在1960年代就已經出現AI的概念,到了2012年隨著深度學習技術成熟而有重大的突破,深度學習中的神經網路模型讓AI可以模擬人類的思考過程,並能夠在某些領域中超越人類的能力。他舉IBM的Deep Blue與DeepMind的AlphaGo分別在西洋棋跟圍棋擊敗人類棋士為例,說明AI學習能力的進步速度非常快。他接著提到,除了下棋,AI還有很多其他應用,包括電腦視覺和醫學影像分析等。

而在2022年,OpenAI推出ChatGPT,這個大型語言模型的出現是AI在自然語言處理的一大突破。ChatGPT能夠使用人類的自然語言進行對話,儘管回答不一定正確,但其表現的類似人類的能力讓人類與AI的互動變得更加自然。在大型語言模型的訓練過程中,AI能夠從網路上得到大量的資料,並以此來訓練模型和生成內容。這樣的能力使得AI在文本創作、情感分析、資料檢索等方面都可以有很好的表現。然而,AI仍然存在一些問題,例如:「幻覺現象」,在生成內容時,AI可能會產出不真實或錯誤的資訊。因此目前還是需要人類把關AI產出的內容。

人工智慧的倫理問題,慈悲是解方

隨著大型語言模型越來越廣泛地被應用,模型內部的偏見問題變得更加明顯。由於訓練它的資訊來源充滿各種觀點,其中甚至包含一些錯誤的訊息。因此,AI使用的倫理道德問題是我們必須重視的。

AI與人類的大腦有一些相似之處,人類的大腦透過感官接收訊息並做出反應。此外,人類可以透過不斷地練習來控制情緒,並培養出同理心與利他思想。練習的過程就如同AI的訓練,我們期望訓練後的AI能產出更具同理心的內容。

在訓練AI的過程中,不僅要讓它能夠理解和回應問題,還要讓它具備正確的價值觀。廖院長以慈濟為例,如果我們能夠將慈濟的人文價值融入大型語言模型中,那麼我們就可以確保AI在與人類互動時,能夠展現出關懷和同理心,而不僅僅是機械式的反應,但這需要大量的訓練和努力。

廖院長指出,慈濟的運作就像AI系統一樣,慈濟志工們如同神經元,接收並分享世界的苦難,把訊息傳遞給證嚴上人。證嚴上人透過佛法的智慧制定策略,再透過慈濟志工去幫助苦難的人。這種模式下,慈濟志工們這些「神經元」都被「佛法」這個參數訓練過,而且不僅是短暫地接觸,而是長時間以來的訓練。佛法教導我們以智慧的眼光看待眾生的苦難,並轉化成模型裡的參數。讓志工在面對苦難時,知道應該如何反應,這正是AI的基本工作原理。

日新月異的科技深深地改變人類的生活。廖院長說,下一代的孩子大部分的學習會來自於大型語言模型。因此我們需要確保這些模型的價值觀與人類社會的發展相符,所以我們需要讓AI具有人文關懷,尤其是有慈濟精神的大型語言模型,才能夠將這種精神傳承下去。

最後,廖院長再次強調「人」在AI發展中的重要性。無論AI技術如何進步,人類的智慧和道德價值觀始終是不可或缺的。他呼籲大家共同努力,讓AI成為服務人類的工具,而非取代人類的存在。

透過廖院長的說明,讓大家重新思考,在這個科技迅速發展的時代,AI在我們的生活中將變得無處不在,如何平衡科技進步與人文關懷的關係,端看人類使用AI的智慧。

與前教育部部長蔣偉寧右贈送小行星銘版給證嚴法師(中),感念其對世人的貢獻。-300x200.jpg)